文章目錄

操作 SEO 的人們對「索引」這一詞不會感到陌生,若是想讓搜尋引擎準確索引,那麼熟悉「 robots.txt 」此文本檔案,將能讓您的網站優化過程中有所助益,本篇教學將提供 2024年最新的 robots.txt 運用技巧,懂得如何撰寫和運用,讓網站 SEO 成效更上一層樓!

robots.txt 是什麼?

robots.txt 是一個存放在網站根目錄下的簡單文字檔案,用來告訴搜尋引擎爬蟲哪些頁面可以被爬取,哪些頁面不可以被爬取。robots.txt 由一行行的指令組成,每行指令由一個動作和一個路徑組成。

robots.txt 的指令有兩種:

- Allow:允許搜尋引擎爬取指定的路徑。

- Disallow:禁止搜尋引擎爬取指定的路徑。

robots.txt 的基本程式碼與結構

或許許多人一看到程式碼就感到很害怕,或是覺得 robots.txt 的程式碼結構複雜。但其實它的規則非常簡單直觀:

| 意思 | 填寫內容 | |

| User-agent | 針對這條規則的對象 | ex. Googlebot、Bingbot |

| Disallow | 指定不想讓爬蟲訪問的網址或目錄 | 某資料夾程式代碼ex. /private/ |

| allow | 指定讓爬蟲訪問的網址或目錄 | 某資料夾程式代碼ex. /private/ |

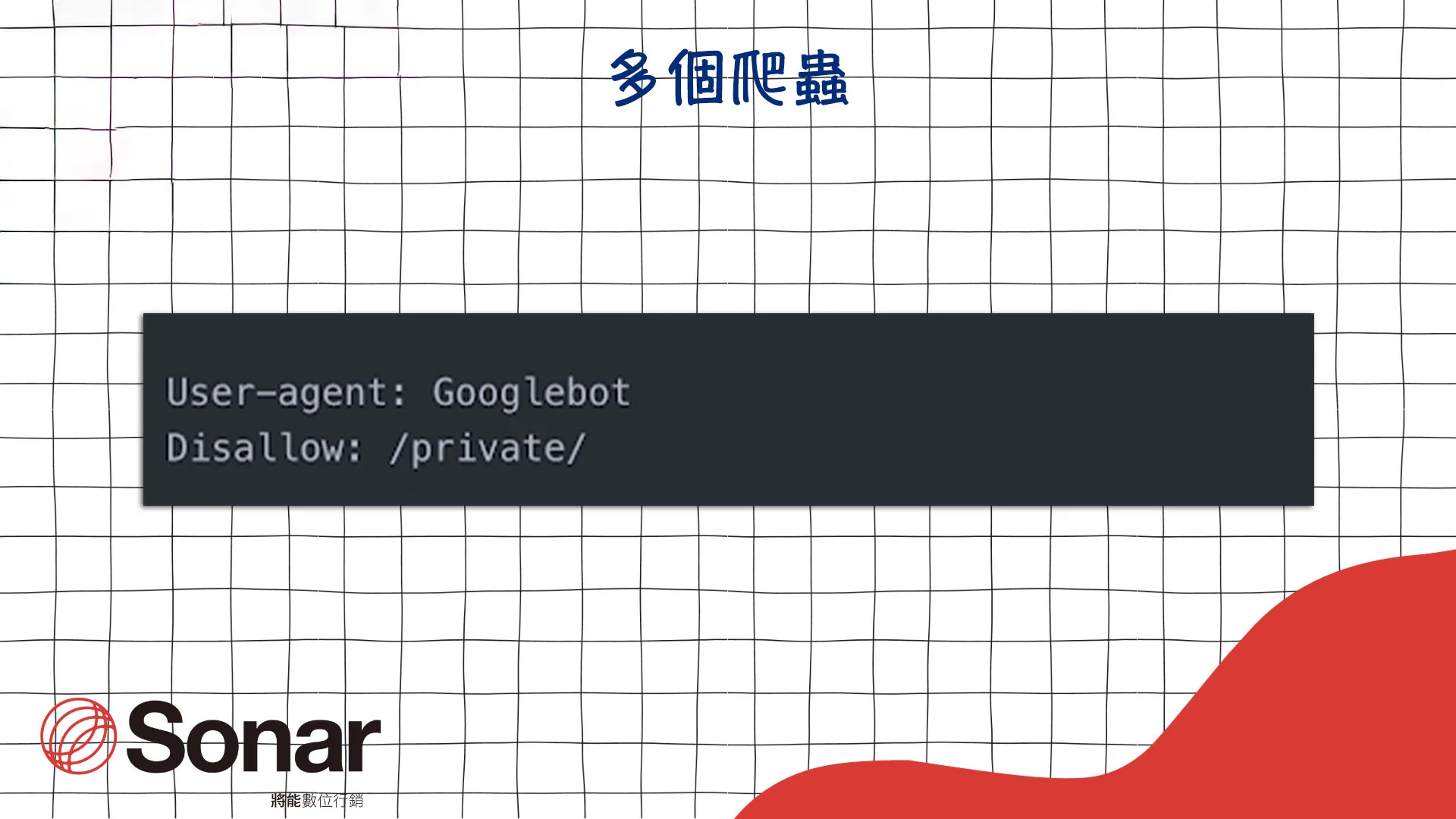

指定給特定爬蟲,就需要在「User-agent」後,填上搜尋引擎的爬蟲代碼,以 Google 爬蟲為例,需填寫Googlebot

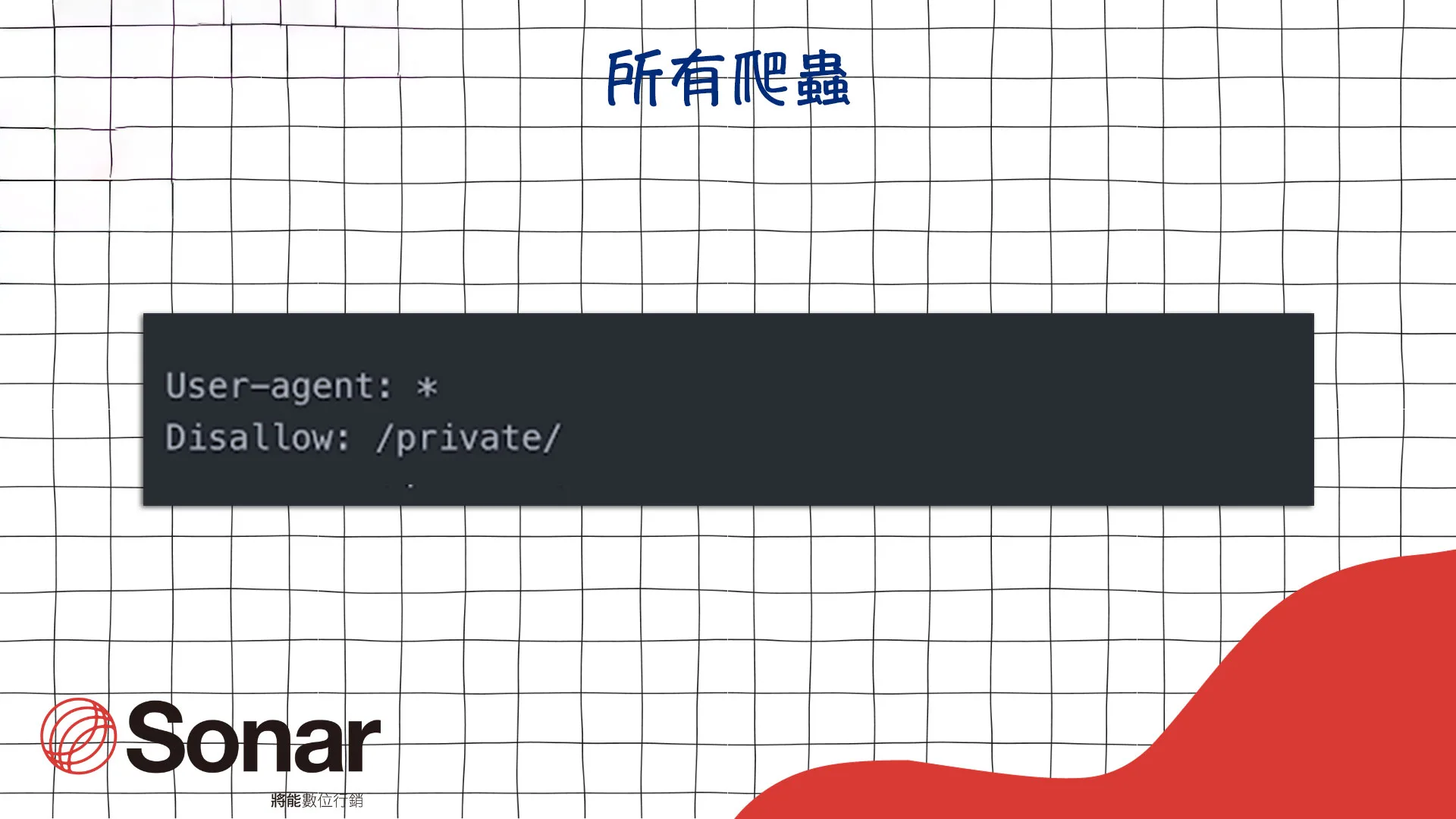

若要指定給所有爬蟲:則在「User-agent」後,填上「*」,就能應用於所有爬蟲。

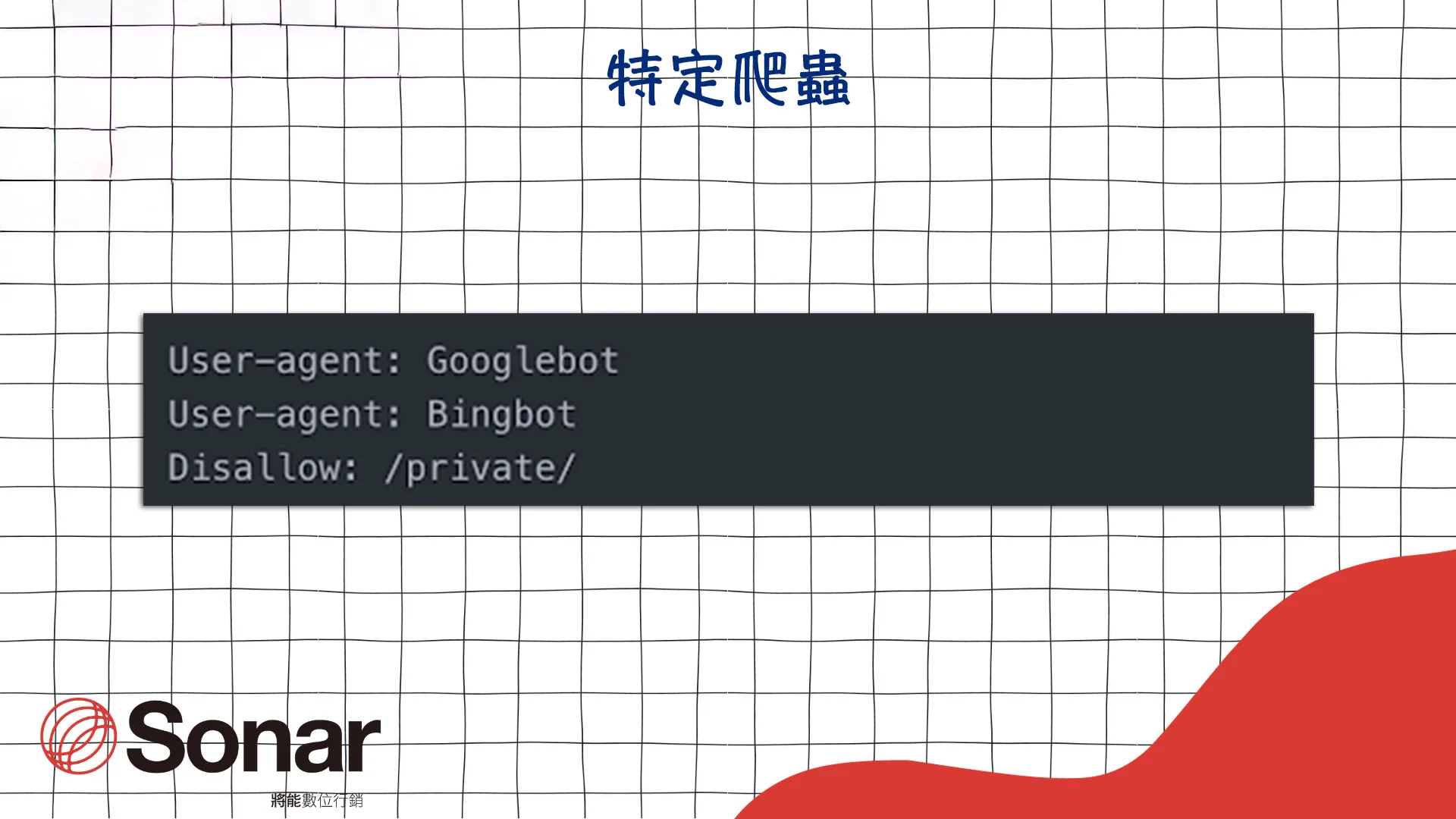

也可以指定多個爬蟲:就是添加多行的「User-agent:」指令 ,若使用下圖程式碼,就能使 Google 和 Bing 的爬蟲需要遵守同一條 Disallow 規則。

總結一下,User-agent 可以根據實際需求,針對特定爬蟲、所有爬蟲或多個爬蟲進行組合設定。

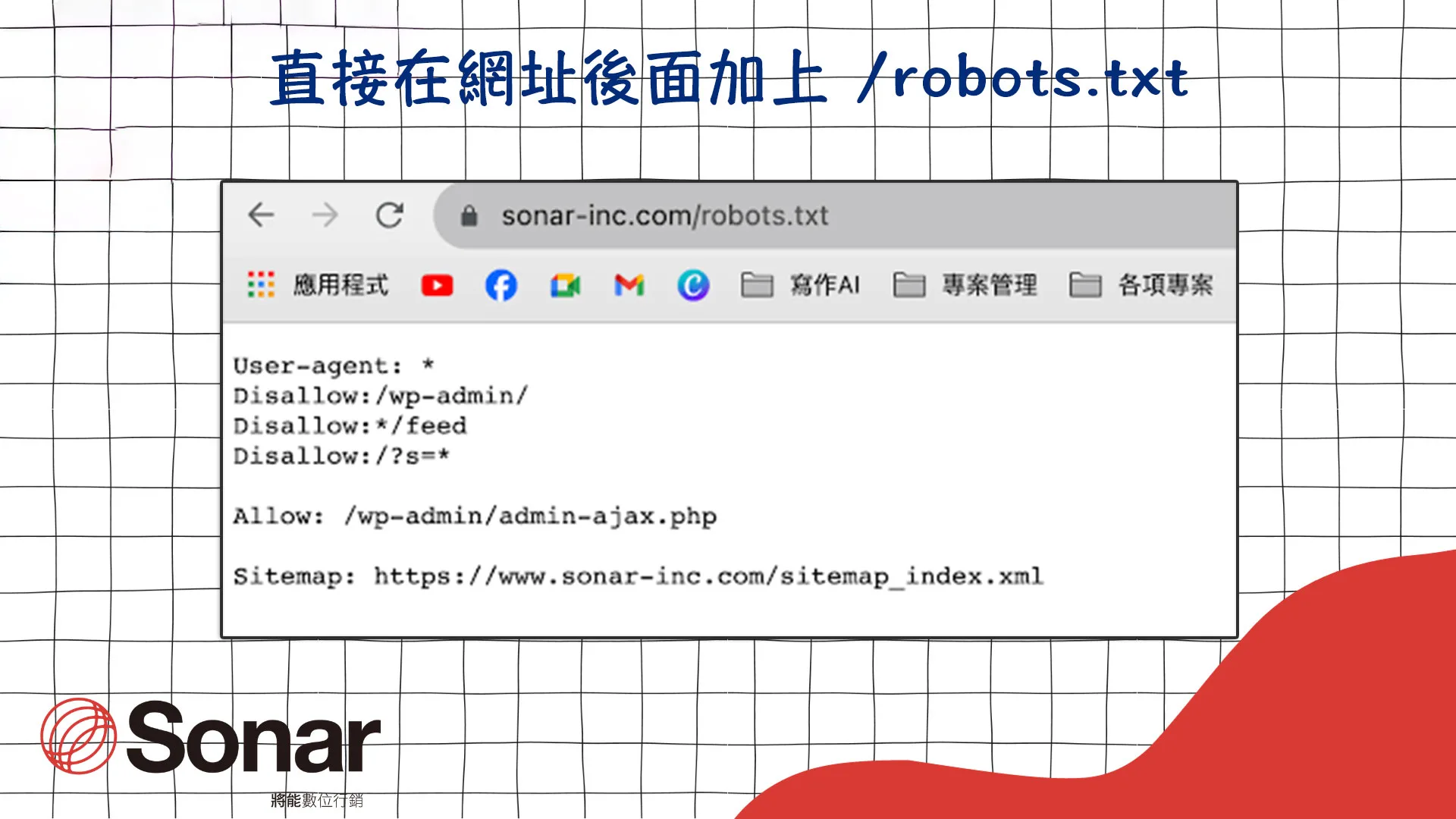

如何找到網站的 robots.txt

直接在網址後面加上 /robots.txt

例如網站是 https://www.sonar-inc.com

那麼 robots.txt 的網址就是 https://www.sonar-inc.com/robots.txt

使用爬蟲工具和SEO工具

在 Screaming Frog、Ahrefs、SEMrush 等 SEO 工具中,輸入網址進行爬蟲,就可以在工具結果中查看該網站的 robots.txt。

查看網站原始碼:

通常可以在 <head> 標籤內找到 robots meta 標籤,代表網站有使用 robots.txt

robots.txt 如何運作

robots.txt 文件的作用是告訴搜尋引擎爬蟲哪些頁面它們可以訪問,哪些頁面它們不應該訪問。這有助於確保搜尋引擎爬蟲只索引你希望被索引的內容,從而提高網站的能見度和檢索效率。

PS:需要注意的是,robots.txt 只是一個建議,而不是一個絕對的禁令。

一些不道德的爬蟲可能會忽略這個文件,因此,網站持有者不應該依賴它來保護敏感信息,對於關鍵隱私內容,最好採取其他更加強有力的保護措施,例如密碼保護或其他身份驗證方式。

robots.txt 對 SEO 的影響

robots.txt 對 SEO 的正面影響

- 幫助搜尋引擎更有效地爬取網站。robots.txt 可以告訴搜尋引擎哪些頁面是可以爬取的,哪些頁面是不可以爬取的。這可以幫助搜尋引擎更有效地爬取網站,並收錄重要的內容。

- 避免搜尋引擎爬取不必要的頁面。網站上可能會有一些不必要的頁面,例如測試頁面、後台管理頁面等。這些頁面不應該被搜尋引擎爬取,因為它們不會對搜尋引擎結果產生任何幫助。robots.txt 可以用來禁止搜尋引擎爬取這些頁面。

- 保護網站安全。robots.txt 可以用來禁止搜尋引擎爬取敏感的頁面,例如包含商業機密的頁面。這可以幫助保護網站安全。

robots.txt 對 SEO 的負面影響

- 影響網站的排名:如果 robots.txt 設置不當,可能會導致搜尋引擎無法爬取重要的頁面,從而影響網站的排名。

- 降低網站的流量:如果 robots.txt 禁止搜尋引擎爬取重要的頁面,這些頁面就無法在搜尋引擎結果中顯示,從而降低網站的流量。

因此,在使用 robots.txt 之前,需要仔細考慮其對 SEO 的影響。如果 robots.txt 設置不當,可能會對 SEO 產生負面影響。

以下是一些建議,可以幫助您更好地利用 robots.txt 提高 SEO成效:

- 只禁止不必要的頁面:只要有禁止不必要的頁面,才能讓搜尋引擎更有效地爬取網站。

- 定期檢查 robots.txt 文件:網站的內容可能會隨著時間的推移而發生變化。因此,需要定期檢查 robots.txt 文件,確保它仍然符合您的需求。

- 使用 robots.txt 工具:有許多可以幫助您生成和管理 robots.txt 文件的工具。使用這些工具可以幫助您更輕鬆地使用 robots.txt。

綜上所述,robots.txt 是個非常有用的工具,正確運用可以優化網站SEO。希望這篇入門指南能幫助大家更理解它的運作方式!如果說對以上內容還有疑問,需要專業人員協助,也都歡迎聯繫我們將能數位行銷呦!

延伸閱讀: